Dunia AI untuk software development sudah mengalami perkembangan yang sangat pesat. Persaingan untuk coding agent cli sudah makin banyak. Mulai dari claude-code, gemini-cli dan yang terbaru sekarang adalah Qwen3-Coder 480B.

Apa itu Qwen Coder 480B?

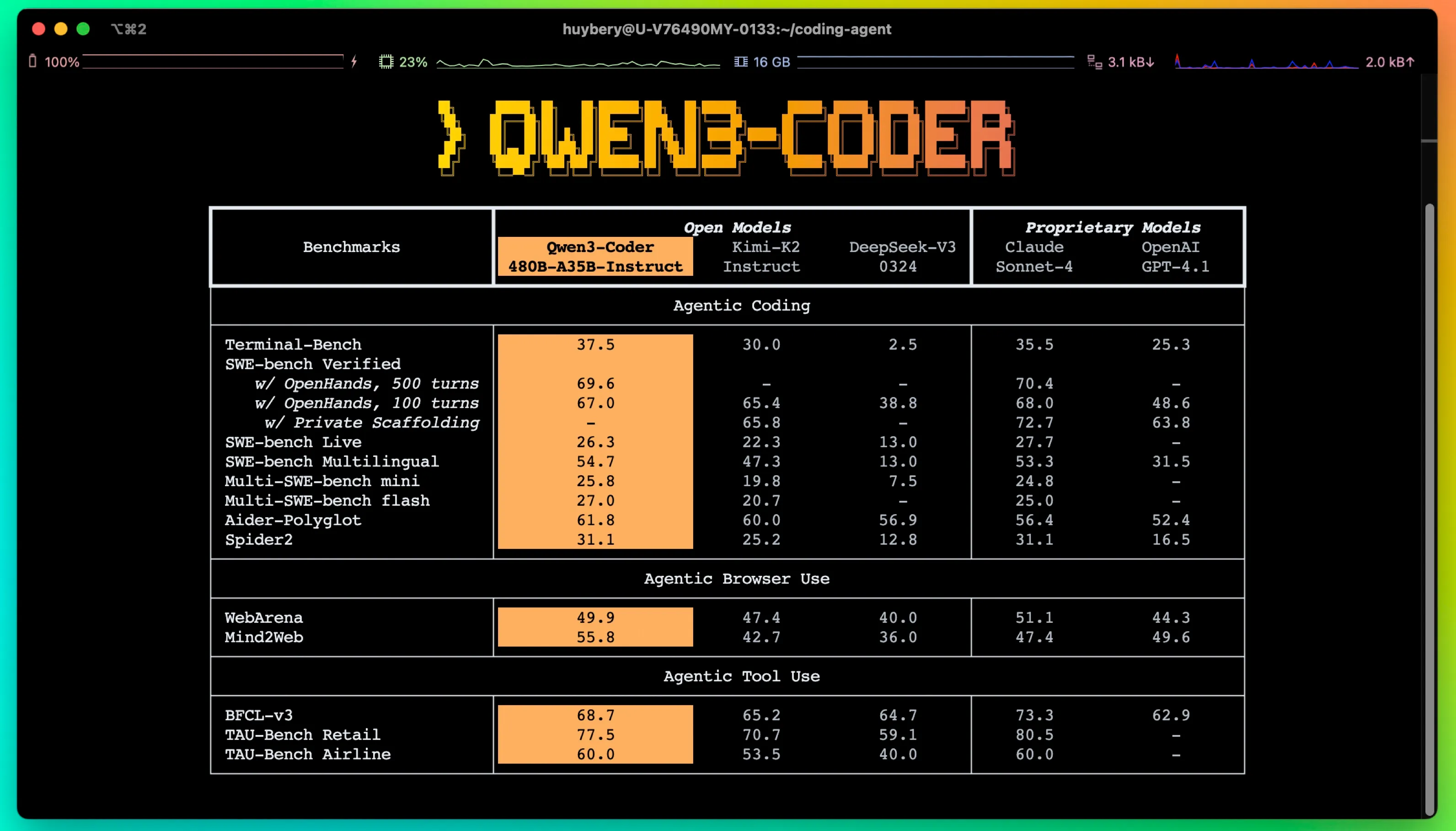

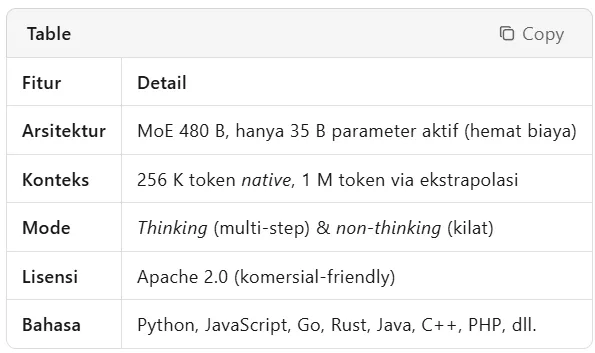

Qwen3-Coder dari Alibaba adalah model Mixture-of-Experts (MoE) dengan 480 miliar parameter dan 35 miliar parameter aktif, yang dirancang untuk mendukung tugas pengkodean konteks besar—menangani 256 ribu token secara native (dan hingga 1 juta dengan metode ekstrapolasi). Model ini pertama kali di rilis di blog Qwen pada July 22, 2025

Qwen3-Coder memperkuat fondasi melalui pra-pelatihan multi-dimensi: 7,5 T token—70 % kode—mempertahankan kemampuan umum dan matematika; konteks native 256 K, extensible hingga 1 M via YaRN untuk repo-scale dan data dinamis seperti Pull Request; serta pembersihan data sintetis menggunakan Qwen2.5-Coder untuk meningkatkan kualitas dataset.

Pasca-pelatihan difokuskan pada dua skala RL. Code RL memanfaatkan “hard-to-solve, easy-to-verify” paradigm: test case otomatis pada ragam tugas dunia-nyata menghasilkan instance latihan berkualitas tinggi, mendorong eksekusi sukses sekaligus transfer gain ke task non-kode. Long-horizon RL (Agent RL) menargetkan interaksi multi-turn dengan lingkungan; 20 000 environment parallel di Alibaba Cloud memungkinkan pembelajaran end-to-end pada SWE-Bench Verified tanpa test-time scaling, menghasilkan SOTA di kalangan model open-source.

Benchmark SWE-Bench Verified & CodeForces ELO setara Claude 3.5 & GPT-4.

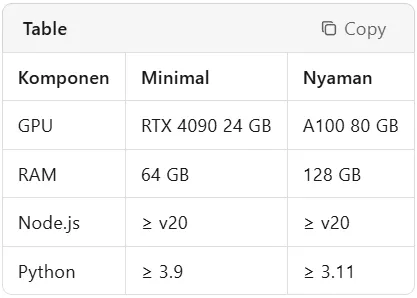

Tip: Hardware pas-pasan? Langsung ke Metode 3 (CometAPI) tanpa GPU.

Cara Menginstal Qwen Coder

1. Metode CLI: Qwen Code (Dev-Ops Friendly)

Instalasi global

Shell

# via npm

npm install -g @qwen-code/qwen-code

# atau dari source

git clone https://github.com/QwenLM/qwen-code.git

cd qwen-code && npm install && npm install -g .Konfigurasi API Key

Shell

export OPENAI_API_KEY="sk-xxxxxxxx"

export OPENAI_BASE_URL="https://dashscope-intl.aliyuncs.com/compatible-mode/v1"

export OPENAI_MODEL="qwen3-coder-plus"Contoh penggunaan

Shell

# REPL interaktif

qwen

> Generate REST API in Express.js with JWT auth & rate-limitingHasilnya langsung siap dipakai

JavaScript

// Auto-generated

const express = require('express');

const jwt = require('jsonwebtoken');

const rateLimit = require('express-rate-limit');Refactor file langsung

Shell

qwen code file-complete --file ./src/auth.js2. Metode Python Transformers (Data Scientist & MLE)

Instal dependensi

Shell

pip install transformers torch accelerateLoad model langsung di python code

Python

from transformers import AutoModelForCausalLM, AutoTokenizer

import torch

model_name = "Qwen/Qwen3-Coder-480B-A35B-Instruct"

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype=torch.bfloat16,

device_map="auto"

)

prompt = """# Tugas: deteksi outlier kolom numerik

import pandas as pd

def detect_outliers(df, column):"""

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=256)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))Gunakan load_in_8bit=True di RTX 4090 untuk hemat VRAM.

3. Metode CometAPI (Tanpa GPU, Langsung Produksi)

1. Daftar API Key

Kunjungi https://cometapi.com → Sign up → salin sk-xxx.

2. Contoh cURL

Shell

curl https://api.cometapi.com/v1/chat/completions \

-H "Authorization: Bearer sk-xxx" \

-H "Content-Type: application/json" \

-d '{

"model": "qwen3-coder-plus",

"messages": [

{"role": "user", "content": "Buatkan SQL query untuk mencari duplikat email di tabel users"}

],

"temperature": 0.2,

"max_tokens": 512

}'SDK Node JS

JavaScript

import OpenAI from 'openai';

const openai = new OpenAI({

apiKey: 'sk-xxx',

baseURL: 'https://api.cometapi.com/v1'

});

const completion = await openai.chat.completions.create({

model: 'qwen3-coder-plus',

messages: [{ role: 'user', content: 'Refactor React component ke TypeScript strict' }]

});

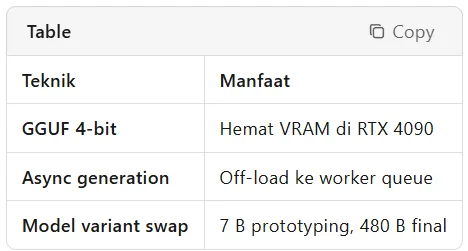

console.log(completion.choices[0].message.content);Optimasi Biaya

Kalian bisa mengoptimasi biaya dengan memperhatikan tabel berikut:

Optimasi Qwen Coder

Penutup

Jadi, apakah Qwen3-Coder akan menggantikan developer? Tidak. Ia justru menjadi katalis yang mempercepat setiap ide, refactor, dan eksperimen kita. Tiga metode di atas CLI untuk dev-ops yang ingin otomatisasi tanpa drama, Transformers untuk tim data yang butuh kontrol penuh, dan CometAPI untuk startup yang ingin langsung produksi tanpa mikir GPU bisa dipilih sesuai kebutuhan dan kantong.

Mulai sekarang sisihkan 30 menit untuk mencoba satu contoh prompt, bagikan hasil di forum DEVMODE, dan saksikan bagaimana baris kode yang tadinya memakan hari kini rampung dalam hitungan jam. Karena di era AI, yang bertahan bukan mereka yang paling cepat mengetik, melainkan mereka yang paling cepat belajar.

Punya Produk Keren? Showcase Sekarang!

Dapatkan feedback, users, dan eksposur dari komunitas kreator, developer, dan entrepreneur digital Indonesia.

Submit Produk → Pelajari Dulu